<h1 align="center">

<a href="https://prompts.chat">

<div align="center">

Sign in to like and favorite skills

LangfuseはオープンソースのLLMエンジニアリングプラットフォームです。

チームが共同でAIアプリケーションを開発、監視、評価、およびデバッグするのを支援します。

Langfuseは数分でセルフホスト可能で、多くの実績を持つシステムです。

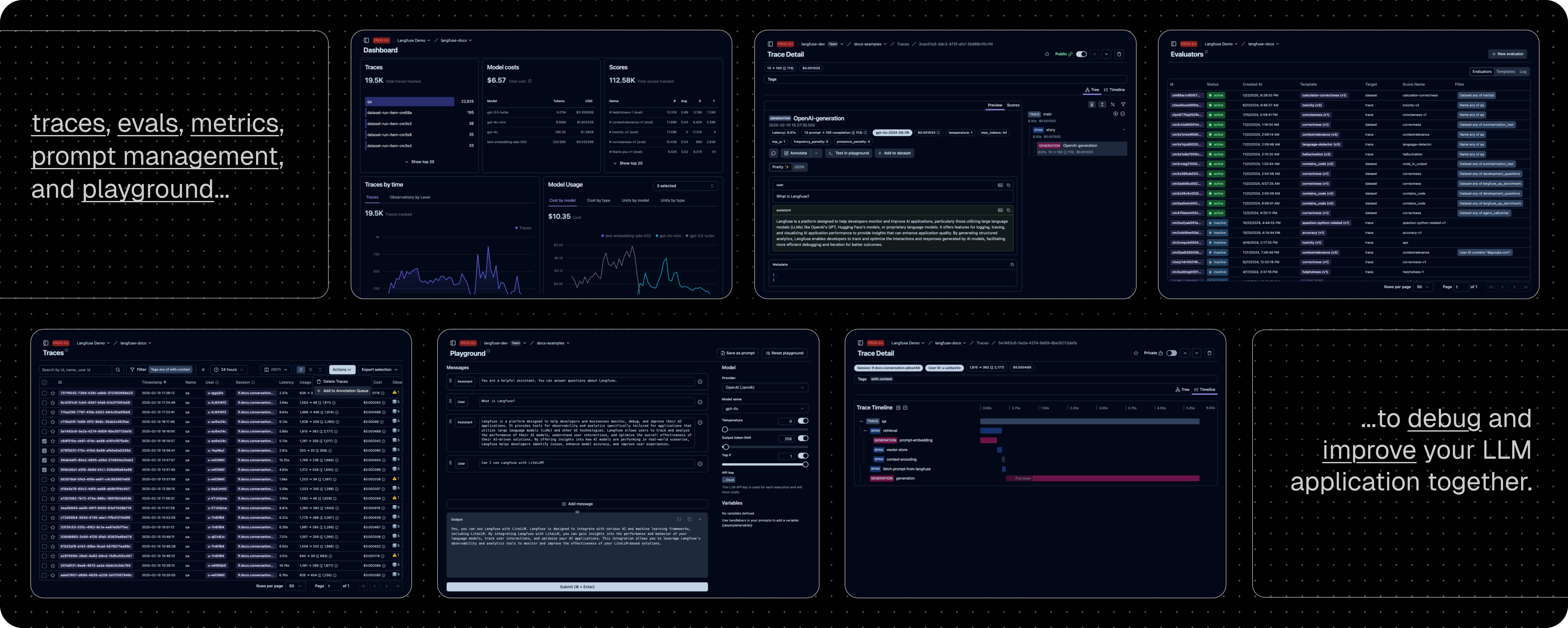

LLMアプリケーションの可観測性:

アプリケーションにインストゥルメンテーションを導入し、Langfuseへトレースを取り込むことで、LLM呼び出しやリトリーバル、埋め込み、エージェントアクションなどの関連ロジックを追跡できます。

複雑なログやユーザーセッションを解析・デバッグできます。

インタラクティブなデモで動作を確認してください。

プロンプト管理:

プロンプトを一元管理し、バージョン管理しながら共同で改善を行えます。

サーバーおよびクライアント側で強力なキャッシングを行うため、アプリケーションのレイテンシを増やすことなくプロンプトの改良が可能です。

評価:

評価はLLMアプリケーション開発ワークフローの要であり、Langfuseは多様なニーズに対応します。

LLMを判定者として用いる方法、ユーザーフィードバックの収集、手動によるラベリング、API/SDKを通じたカスタム評価パイプラインをサポートします。

データセット:

LLMアプリケーション評価用のテストセットやベンチマークを構築できます。

継続的な改善、事前デプロイテスト、構造化された実験、柔軟な評価、さらにLangChainやLlamaIndexなどとのシームレスな統合をサポートします。

LLMプレイグラウンド:

プロンプトやモデル設定のテスト・反復作業を支援するツールで、フィードバックループを短縮し開発を加速します。

トレースで不具合が見つかった場合、直接プレイグラウンドへ飛び、迅速に改善できます。

包括的なAPI:

LangfuseはAPIを通じて提供されるビルディングブロックを用い、カスタムLLMOpsワークフローの基盤として頻繁に利用されます。

OpenAPI仕様、Postmanコレクション、PythonやJS/TS向けの型付きSDKが利用可能です。

Langfuseチームによるマネージドデプロイメント。充実した無料プラン(ホビープラン)で、クレジットカード不要です。

自身のインフラ上でLangfuseを実行できます:

Local (docker compose):

Docker Composeを使用して、たった5分で自分のマシン上でLangfuseを実行できます.

# 最新のLangfuseリポジトリのコピーを取得 git clone https://github.com/langfuse/langfuse.git cd langfuse # Langfuseのdocker composeを起動 docker compose up

Kubernetes (Helm):

Helmを使用してKubernetesクラスター上でLangfuseを実行します。

こちらが推奨される本番環境でのデプロイ方法です。

VM:

Docker Composeを使用して、単一の仮想マシン上でLangfuseを実行します。

セルフホスティングのドキュメントを参照し、アーキテクチャや設定オプションの詳細をご確認ください。

| インテグレーション | 対応言語・環境 | 説明 |

|---|---|---|

| SDK | Python, JS/TS | SDKを利用して手動でインストゥルメンテーションを実装し、完全な柔軟性を提供します。 |

| OpenAI | Python, JS/TS | OpenAI SDKのドロップイン置換による自動インストゥルメンテーションを実現します。 |

| Langchain | Python, JS/TS | Langchainアプリケーションにコールバックハンドラーを渡すことで自動的に計測します。 |

| LlamaIndex | Python | LlamaIndexのコールバックシステムを介して自動的にインストゥルメントします。 |

| Haystack | Python | Haystackのコンテンツトレースシステムを利用した自動インストゥルメンテーションを実現します。 |

| LiteLLM | Python, JS/TS (proxy only) | GPTのドロップイン置換として任意のLLMを使用できます。Azure、OpenAI、Cohere、Anthropic、Ollama、VLLM、Sagemaker、HuggingFace、Replicate(100+ LLM)に対応。 |

| Vercel AI SDK | JS/TS | React、Next.js、Vue、Svelte、Node.jsを使用してAI搭載アプリケーションの構築を支援するTypeScriptツールキットです。 |

| API | 公開APIを直接呼び出すことが可能です。OpenAPI仕様も利用できます。 |

| 名前 | タイプ | 説明 |

|---|---|---|

| Instructor | ライブラリ | 構造化されたLLM出力(JSON、Pydantic)を取得するためのライブラリ |

| DSPy | ライブラリ | LLMプロンプトや重み付けを体系的に最適化するためのフレームワーク |

| Mirascope | ライブラリ | LLMアプリケーション構築用のPythonツールキット |

| Ollama | モデル(ローカル) | オープンソースLLMを手軽にローカルで実行するためのツール |

| Amazon Bedrock | モデル | AWS上でファウンデーションモデルやファインチューニング済みモデルを実行 |

| Google VertexAI and Gemini | モデル | Google上でファウンデーションモデルやファインチューニング済みモデルを実行 |

| AutoGen | エージェントフレームワーク | 分散型エージェント構築のためのオープンソースLLMプラットフォーム |

| Flowise | チャット/エージェント UI | JS/TSのノーコードビルダーで、カスタマイズ可能なLLMフローを構築 |

| Langflow | チャット/エージェント UI | PythonベースのUIで、react-flowを用いてLangChainの実験やプロトタイピングを容易に実現 |

| Dify | チャット/エージェント UI | ノーコードでLLMアプリ開発が可能なオープンソースプラットフォーム |

| OpenWebUI | チャット/エージェント UI | 自前ホストおよびローカルモデルに対応するLLMチャットWeb UI |

| Promptfoo | ツール | オープンソースのLLMテストプラットフォーム |

| LobeChat | チャット/エージェント UI | オープンソースのチャットボットプラットフォーム |

| Vapi | プラットフォーム | オープンソースの音声AIプラットフォーム |

| Inferable | エージェント | 分散型エージェント構築のためのオープンソースLLMプラットフォーム |

| Gradio | チャット/エージェント UI | チャットUIなどのWebインターフェース構築のためのオープンソースPythonライブラリ |

| Goose | エージェント | 分散型エージェント構築のためのオープンソースLLMプラットフォーム |

| smolagents | エージェント | オープンソースのAIエージェントフレームワーク |

| CrewAI | エージェント | エージェントの協調とツール利用を実現するマルチエージェントフレームワーク |

アプリケーションにインストゥルメンテーションを導入し、LLM呼び出しやリトリーバル、埋め込み、エージェントアクションなどの動作をLangfuseに記録しましょう。

複雑なログやユーザーセッションの解析・デバッグが可能になります。

デコレーターを利用することで、任意のPython製LLMアプリケーションのトレースが簡単に行えます。@observe()

このクイックスタートでは、LangfuseのOpenAI統合を使用して、全てのモデルパラメータを自動で取得します。

[!TIP] OpenAIを利用していない場合は、こちらのドキュメントで、他のモデルやフレームワークのログ記録方法をご確認ください。

pip install langfuse openai

LANGFUSE_SECRET_KEY="sk-lf-..." LANGFUSE_PUBLIC_KEY="pk-lf-..." LANGFUSE_BASE_URL="https://cloud.langfuse.com" # 🇪🇺 EUリージョン # LANGFUSE_BASE_URL="https://us.cloud.langfuse.com" # 🇺🇸 USリージョン

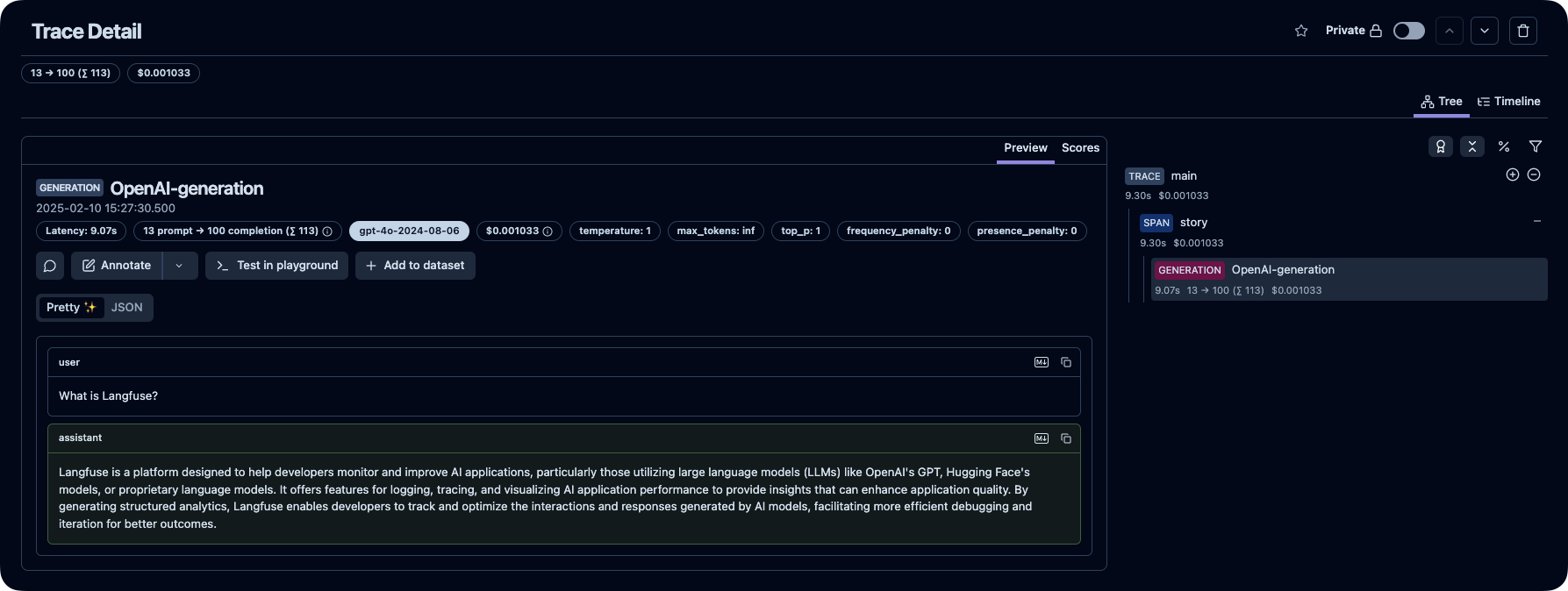

from langfuse import observe from langfuse.openai import openai # OpenAI統合 @observe() def story(): return openai.chat.completions.create( model="gpt-4o", messages=[{"role": "user", "content": "What is Langfuse?"}], ).choices[0].message.content @observe() def main(): return story() main()

Langfuse上で、LLM呼び出しおよびその他のアプリケーションロジックのトレースを確認できます。

[!TIP]

Langfuseでのトレースの詳細については、こちらをご参照いただくか、インタラクティブデモでお試しください。

質問の回答をお探しの場合は:

サポートチャネル:

皆様からの貢献を歓迎します!

このリポジトリは、

eeLangfuseを利用している主要なオープンソースPythonプロジェクト(スター数順): (出典)

データのセキュリティとプライバシーは非常に重要です。

詳細につきましては、セキュリティとプライバシーページをご参照ください。

デフォルトでは、Langfuseは以下の目的でセルフホストされたインスタンスの基本的な使用統計情報を中央サーバ(PostHog)へ自動的に報告します。

収集されたデータは第三者と共有されず、機微な情報は一切含まれていません。

当社はこの点について極力透明性を保っており、収集される具体的なデータの詳細はこちらで確認できます。

TELEMETRY_ENABLED=false